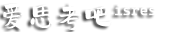

最近自己在学习AI知识需要好显卡,但由于显卡太贵,于是个人拓展了自己对显卡知识的了解,以方便自己不再局限于30、40系列的了解,以方便在有限的经济下找最合适的显卡。

找到了一个算例租用平台,得到了低成本测试不同显卡的机会,只测试比我本机3080显存更大的型号,A100没有机会测试,一直没有空闲GPU。

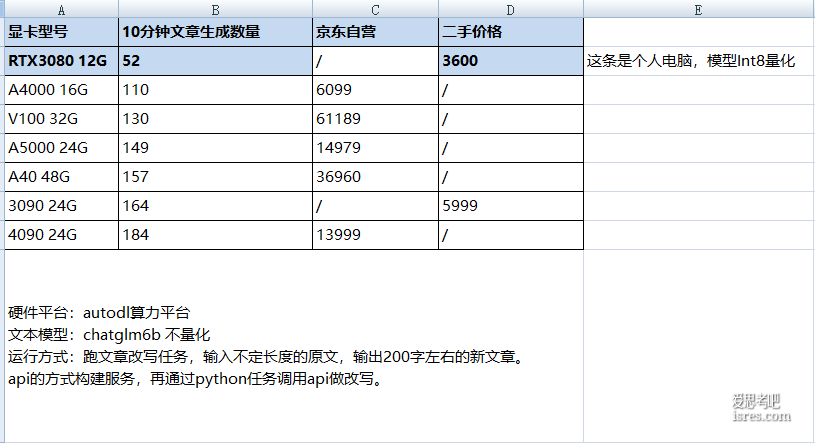

测试介绍如下:

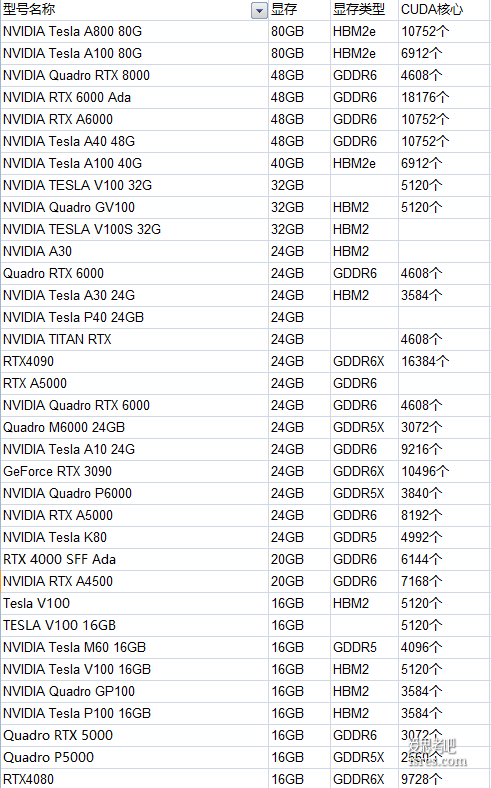

硬件平台:autodl算力平台

文本模型:chatglm6b 不量化

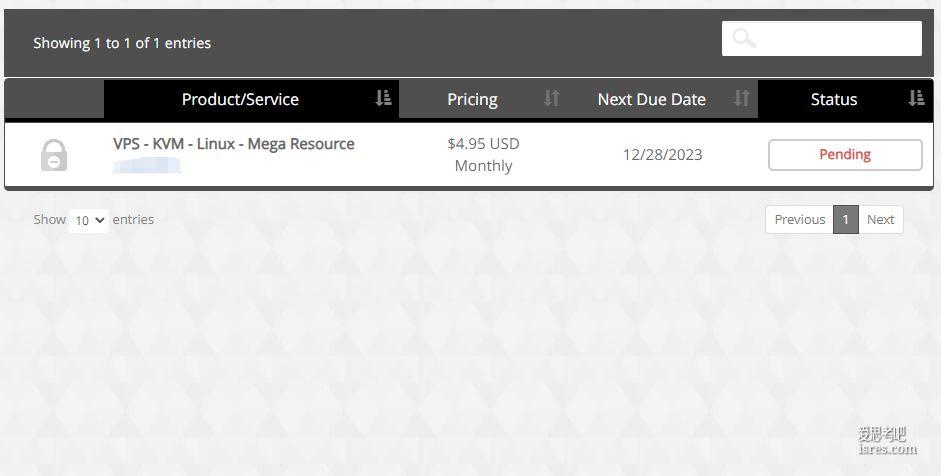

运行方式:跑文章改写任务,输入不定长度的原文,输出200字左右的新文章

api的方式构建服务,再通过python任务调用api做改写

结论与疑问如下:

1、结论是 速度最快的确实是4090,果然是历史最强显卡,但对标我个人电脑的3080显卡,也就快3.5左右,对标其它型号也没有达到2倍速度,也就是说所测显卡的生成内容速度差距不超过2倍。

2、疑问点是 V100明明不如A40的生成速度,显存也不如A40,但却贵一倍价格。

测试结果截图:

测试过程截图:

本文《100元成本测试autodl算例平台上各显卡跑大型模型的性能,如a40、V100、4090》由爱思考吧 isres.com 分享,转载请注明出处。本文网址:https://www.isres.com/fuwuqi/60.html

本站主要收集测评能够节省时间和提升效率的软件工具并分享使用与学习的过程和感受,任何情况下用户都需遵守所使用软件资源的相关协议。与《100元成本测试autodl算例平台上各显卡跑大型模型的性能,如a40、V100、4090》有关的本站文章及资源仅供个人学习交流使用,相关资源请下载后24小时内删除,请勿用于其它用途,因此产生的任何问题由您自行承担。